Kontakt

Helpdesk

Telefon: 0345 55 21 888

helpdesk@itz.uni-halle.de

Kurt-Mothes-Str. 1

06120 Halle (Saale)

Sie erreichen uns

Montag - Freitag von

9:00 Uhr - 15:00 Uhr

2. Architektur und Technische Parameter IBM-575 HPC-Cluster in Halle

Cluster, Computenode, Core/CPU-SMT, Loginserver

- Cluster aus 5*IBM-P575 High-Performance-Computenodes (Design für HPC) mit ff. Computenodes: 1*128 GB, 1*96 GB und 3*64 GB Memory + 1*Login-Server mit 1*32 GB,

- eine IBM-P575 hat 32 Cores IBM-Power6-RISC-Prozessoren mit 4,7 GHz Takt (pro Core: 4 MB L2 und 16/32MB L3 Cache). Jeder Core hat via SMT 2 logische CPU,(SMT = Simultaneous Multi-Threading , d.h. 2 Hardware-Threads pro Core),

- so daß auch das Betriebssystem im entspr. Boot-mode (in Halle alle Nodes) 64 CPU pro 575-Node "sieht". Der Nutzer bestimmt beim Jobstart via Loadleveler ob er aktuell lieber Cores (32 pro Node) oder 64 CPU/SMT nutzen möchte.

- Vorteil bei Nutzung von 64 CPU/SMT: + Durchsatz (Anzahl Jobs pro Zeit): je nach Anwendung mehr als + 50% mgl., wie z.B. bei Gaussian Jobs.

- Flexibler „Mischbetrieb“ von Core und SMT-CPU auf ein- und demselben Node.

- Login Node ist eine IBM 575 mit 4 Core/8 CPU-SMT und 32 GB Memory, „gewonnen“ durch Partitionierung einer IBM 575 mit zuvor 32/64 Core/CPU-SMT und 128 GB Memory, so daß der „Rest“ ausnahmsweise einen Computenode mit 28/56 Core/CPU-SMT und 96 GB Memory ergibt (sonst: 128GB oder 64 GB Memory und 32 Core bzw. 64 CPU-SMT pro Node).

ftp://public.dhe.ibm.com/common/ssi/ecm/de/pod03010dede/POD03010DEDE.PDF

Weitere Details siehe auch:

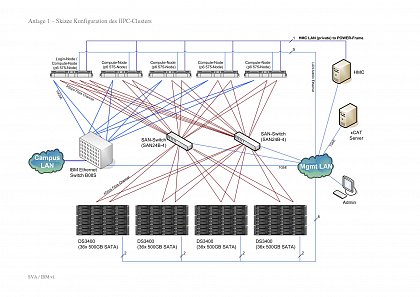

Abb. 1: Skizze HW-Kongiuration des Clusters

Skizze_Konfiguration_HPC-Cluster

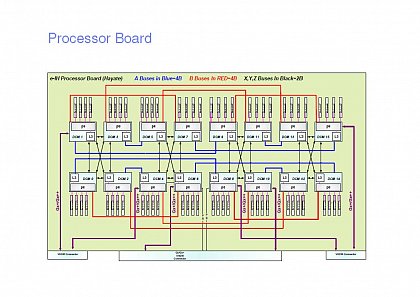

Abb. 2:IBM575 Node: Prozessor-Board P6

Wasserkühlung

Offenes Bord

- Wasserkühlung direkt ab Prozessor + Wasserkühlung Rack (entlastet Raum-Luftkühlung um ca. 80% , spart ca. 50% Strom bei der Kühlung),

- d.h. bei einem System, dass z.B. 30KW Leistungsaufnahme

hat, wären für Luftkühlung noch mal ca. 30KW einzuplanen,

mit Wasserkühlung spart man mit dieser Technologie hier

ca. 15KW - siehe auch ff. Video dazu: http://www.youtube.com/watch?v=jVLQ0zBGjEo&feature=player_embedded#

Kommunikation

- Kommunikation im IBM-575 Knoten: Interne two-tier SMP Fabric:je 8* Cores any-to-any bilden 1 MCM (Multichip Module), pro Node insges. 4 MCM’s any-to-any, /siehe Abbildung 2/

- Gemessene Kommunikationsbandbreite zwischen den

Prozessoren im 575-Node: 130GB/s Netto, d.h. mind.

4GB/s pro Core auch wenn alle Cores gleichzeitig Last haben

(nach STREAM Benchmark In Halle gemessen) - 2*10GE pro 575-Node und zwischen den 575-Nodes

- I/O und GPFS (paralleles Cluster-Filesystem)

- Disk-Array mit 48 TB Netto Raid-Disk auf das via dem

parallelem Filesystem GPFS und SAN mit je 2*8Gbit/s Dual FC

(Fibre Channel) pro Node über „alle“ Pfade direkt und

„kreuzweise“ zugegriffen wird - Alle 575-Compute-Nodes sind gleichzeitig GPFS „Fileserver

und Client“ - I/O Bandbreite Bsp.: 100GB File via GPFS mit 2 NSD Server

und 2 Tasks in Halle gemessen (bei 4 GB vom Memory für

GPFS-Cache): write 2,2 GB/s, read 2 GB/s, d.h. 50 GByte

in 50 s read bzw.45s write(¾min) - Zum Vergleich 50 GB write ff. Bsp.:

(der vorhandene Memory wird bei allen ff. gen.Bsp. z.T bis

zu 100% genutzt - nur bei o.gen. GPFS IBM-Cluster werden

nur die dafür konfigurierten bei uns 4GB vom Memory für

GPFS-Cache genutzt !!!): - galaxy SUN-Opteron-Cluster-x4600 50 GB write zu

clusterinternen Fileserver x4500 via Infiniband und NFS:

ca. 500s (ca. 8min) (x4600 hat 32 GB und x4500 hat 16 GB

Memory) - lokale disk sun-x4600/32GB (16way Opteron SMP-Node im

galaxy Cluster): ca. 800s (ca. 13min); - i86PC mit Solaris10, Dual Core AMD Opteron180/2,4GHz/2GB

Memory: ca. 1800s (30min) - Mac mit Mac OSX Intel Dual Core /2,5GHz/4 GB DDR3 Memory:

ca. 1800s (30min) - PC mit Windows, Intel Dual Core /2,5GHz/2 GB Memory: ca.

1800s (30min)